您现在的位置是:首页 > telegeram中文版官网下载 > 正文

telegeram中文版官网下载

关于tokenization中文的信息

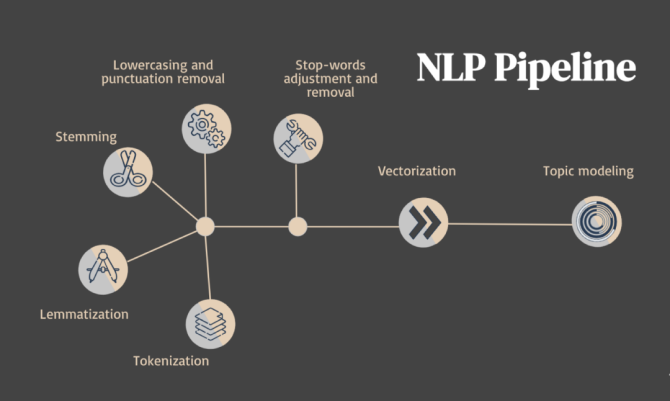

MBSP与Pattern同源,同出自比利时安特卫普大学CLiPS实验室,供给了WordTokenization,语句切分,词性标示,Chunking,Lemmatization,句法剖析等根本的

MBSP与Pattern同源,同出自比利时安特卫普大学CLiPS实验室,供给了Word Tokenization, 语句切分,词性标示,Chunking, Lemmatization,句法剖析等根本的文本处理功用,感兴趣的同学可以重视关于 Python文本处理工具都有哪些,环球青藤。

除了汉语,而且每个单词的字符太多,不能使用基于字符的tokenizationGitHub地址。

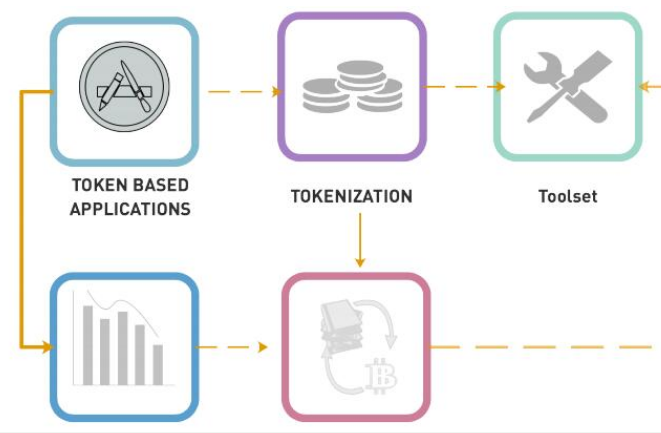

构建中文tokenization一为什么需要 构建中文tokenization?二如何对 原始数据预处理?三如何构建中文的词库?四如何使用。

从文档里面提取单词的过程通常被成为语法分析 parsing 和标记化 tokenization ,这个过程可以产生一系列用于表示文档的标记 token ,有时又被成为单词 word P155 标记化的一个常见的附加步骤就是移除非用词 stop word。

子词分词Subword Tokenization在一些语言模型中,例如BERT和GPT系列模型,采用了子词分词策略,如WordPiece。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~